Retour sur le Breizh Data Day 2023

- La Data et les quartiers

- l’observatoire du domaine S3 d’innovation stratégique

- Décider parmi les architectures Edge/FO… quand les ressources sont manquantes

Le 4 avril dernier s’est tenu le rendez-vous des passionnés de la data du grand ouest, le Breizh Data Day édition 2023. Notre practice Data s’est rendue sur place pour participer aux nombreuses conférences qui y était proposé. Voici notre retour sur cet évènement.

Se déroulant sur une journée, l’évènement a pris place au Village By CA de Ploufragan. Côté organisation, c’est l’organisme Innôzh Technopole qui a orchestré ce bel évènement. Les visiteurs eurent l’occasion d’échanger avec des acteurs locaux mais aussi d’assister à 14 conférences mixant Retours d’expériences et Conférences techniques.

Nos experts vous proposent un debriefing de trois conférences qui ont retenu leur attention autour des thèmes de l’écologie, de la frugalité et de la citoyenneté. Des sujets en lien direct avec notre ligne directrice d’une data plus responsable !

La Data et les quartiers

Retour d’expérience par Romain VALLEE, Chef de projet chez CIVITEO et sur le Programme Data & Quartiers par Réso Villesécologie.

Cette conférence revient sur les enjeux, les défis et les apprentissages du programme expérimental Data & Quartiers menés entre 2019 et 2022. Pendant 3 ans, des méthodologies et des outils Data ont été testés au service des habitants des 78 quartiers prioritaires (QPV) de Bretagne et des Pays de la Loire.

Les cas d’usage partagés en conférence sont liés à des travaux menés pour Resovilles qui regroupe des collectivités de Bretagne et des Pays de la Loire. L’initiative lancée en 2018 venait répondre à 3 objectifs :

- Identifier les enjeux des quartiers et les données sous-jacentes pour y répondre

- Documenter la démarche pour apprendre et utiliser le retour d’expérience sur d’autres territoires

- Capitaliser et vulgariser auprès des collectivités

La démarche retenue devait donc permettre de répondre à la question des apports de la Data sans aller jusqu’à l’industrialisation :

- Cadrage du besoin, choix des cas d’usages

- Validation du cas d’usage et preuve de concept

- Prototypage de la solution et projection dans les processus

Afin de rester dans un cadre respectueux et éthique, les travaux menés ont été labellisés EKITIA. Ce label s’appuie sur un questionnaire qui adresse une centaine de questions sur les thèmes :

- De la souveraineté des données

- Des éventuels biais des algorithmes

- De la prise en compte de l’accessibilité

- De la disponibilité des modèles en Open Source

Cette initiative était l’une des premières permettant le croisement de données issues de sources qui n’étaient pas mise en commun précédemment. Les résultats ont permis de traiter différentes sujets / thèmes comme l’emploi, la santé ou l’enseignement. Voici deux exemples de questions adressées par le programme :

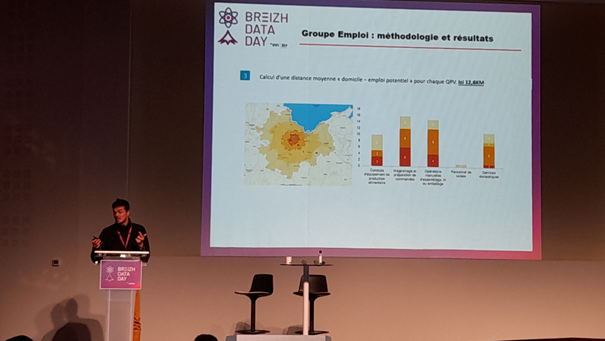

- Data et emploi : Quelle distance entre les demandeurs d’emploi des QPV et les offres d’emploi ?

Afin de répondre à cette question, le programme a collecté les données fournies par Pôle Emploi concernant les emplois recherchés sur le secteur et les a croisées avec la liste des offres d’emplois proposées autour des 78 QPV. Ces dernières ont été fournies par Randstad moyennant une convention d’échange de données et des accords de confidentialité.

- Data et Santé : Quel recours au Complémentaires Santé Solidaire (C2S) dans les QPV ?

L’étude devait permettre de comparer le niveau de non-recours à cette complémentaire entre les QPV et les autres quartiers. Cette analyse permettait ainsi de modéliser les profils des « non recourants » pour engager des actions d’accompagnement adaptées. Les partenaires ayant contribué à cette thématique sont la Caisse Nationale d’Assurance Maladie (CNAM) et l’INSEE.

Ce programme a démontré l’intérêt de croiser les données issues de différentes sources pour en augmenter la valeur et servir les besoins des usagers.

Parmi les freins rencontrés, les verrous contractuels empêchent régulièrement ce type d’initiative. Des accords durables pour le partage de la donnée pourraient ainsi permettre de passer à l’échelle et de dépasser le cadre de l’expérimentation. La mise en place de clauses Data dans les contrats des villes devrait ainsi permettre d’accélérer sur ce type d’initiative.

Enfin, ce retour d’expérience a mis en exergue deux leviers importants pour garantir la réussite d’une telle démarche, à savoir :

- la prise en compte des enjeux démocratiques et politiques qui doit être au cœur de la démarche

- la formation des parties prenantes dans les collectivités.

Pour en savoir plus :

La mise en place de l’observatoire du domaine S3 d’innovation stratégique

Retour d’expérience par Yann DIEULANGARD, coordinateur de l’observatoire du domaine S3 d’innovation stratégique numérique chez Bretagne Développement Innovation

Bretagne Développement Innovation, l’agence régionale de développement économique et le centre de recherches A.I. Driven Business de Rennes School of Business ont lancé en 2020 un Observatoire de l’I.A. et de la Data Science. La conférence porte sur la présentation de cet observatoire, la cartographie de l’écosystème offreurs/demandeurs, le SWOT de la filière et les préconisations formulées pour faire de la région, à l’instar de la Cyber, un acteur majeur de ce secteur.“

L’I.A. et la data science font parties des technologies clés identifiées pour favoriser le développement économique d’un territoire et de ses acteurs. Terre historique du numérique, la Bretagne est un creuset pour la R&D, l’expérimentation et le développement des usages de l’I.A.

Pour présenter le contexte de cette démarche, le projet Smart Specialisation Strategy (S3), porté par l’Europe, se positionne comme « un puissant outil de transformation au service d’une ambition régionale partagée ». Il permet aux régions de concentrer leurs ressources sur les domaines d’innovation pour lesquels elle ont les meilleurs atouts par rapport aux autres régions européennes.

Dans ce cadre, l’Observatoire mis en place a permis de mener une phase d’étude auprès des acteurs de la Région Bretagne (entreprises et laboratoires) pour révéler les enjeux du territoire. Le résultat dévoile que les domaines d’applications de ce territoire sont orientés sur l’agro-alimentaire, l’aquaculture et les télécommunications.

Les Données utilisées pour répondre à ces enjeux ont deux origines principales : les données produites par ces mêmes acteurs, mais aussi des données externes, achetées auprès d’acteurs spécialisés ou récoltées via l’Open Data. Les usages principaux qui en ressortent concernent le Contrôle industriel, la Cybersécurité et la Communication.

L’Intelligence Artificielle est ensuite utilisée sur des applications comme le Contrôle produit qui viennent soutenir ces usages. En revanche, le manque de temps et d’acculturation fait émerger des questionnements sur l’exploitation des patrimoines de données, sur la démarche à suivre face à cette infobésité, mais aussi un manque de sensibilisation à l’éthique de ce type de système.

Pour en savoir plus :

Décider parmi les architectures Edge/FO… quand les ressources sont manquantes

Conférence technique par Loïc EYANGO, Ingénieur Data Scientist – Doctorant CIFRE chez ADVENTIEL

La conférence revient sur les différents leviers utilisés dans le développement de solutions Data frugales dans le domaine Agricole. “La simplification des accès à une puissance de calcul de plus en plus importante ainsi que la réduction des coûts matériels ces vingt dernières années a orienté les développements dans une course à la performance, au détriment parfois des techniques d’optimisation qui primaient à la fin du siècle dernier compte tenu des limites matérielles de l’époque. Dans le contexte géoclimatique du XXIᵉ siècle, il est indispensable de repenser nos usages pour réduire les consommations en énergies et en ressources matérielles ainsi que de limiter certaines pollutions.“

Dans un premier temps, c’est la collecte des données qui est visée. Il nous est présenté que “dans un contexte agricole, beaucoup de source de données sont disponibles. Il faut alors se questionner sur l’utilisation des capteurs pour remonter assez d’informations. Le transfert de ces mêmes données est aussi questionné pour ne communiquer que les données pertinentes. La technologie embarquée dans les capteurs peut ainsi limiter le flux de données transmis pour ne transmettre que les données utiles. Dans un exemple lié à l’élevage porcin, le déclenchement de la transmission des données sonores peut par exemple se faire sur détection de l’éternuement d’un animal. Le déclenchement sur évènement limite ainsi le volume de données transmis, stocké et retraité.“ [Le stockage est brièvement abordé, notamment via l’effet Simpson.]

Le paradoxe de Simpson est l’inversion d’une tendance statistique lors de l’éclatage de la population statistique en sous-catégories d’un nouvel attribut. <lien sciences étonnantes>. En regardant les résultats pour chaque catégorie, nous nous exposons à un changement de la tendance. L’idée ici est de poser un cadre sur les données que l’on collecte pour collecter peu de données tout en garantissant l’intégrité du niveau d’analyse. Collecter plus d’attributs pourrait inverser la tendance de l’analyse, mais collecter pour vérifier cela est en contradiction avec la frugalité de la collecte.

Le speaker évoque ensuite l’apprentissage des modèles, “le Transfer Learning et le Few Shot Learning comme méthodes frugales du Machine Learning“. Ces alternatives permettent d’envisager des optimisations non négligeables dans le domaine de l’Intelligence Artificielle pour l’apprentissage des modèles en évitant un apprentissage continu sur des jeux de données complets. Pour vulgariser ces approches, voici quelques précisions :

- Le Few Shot Learning se caractérise par un entrainement d’un modèle déjà existant, sur un petit jeu de données. Dans un contexte de classification, l’idée serait d’entrainer le modèle avec idéalement 1 exemple d’une classe. L’augmentation de données, l’apprentissage multitâches, sont d’autant de manières de réaliser cette méthodologie. <lien kongakura sur le few shot learning>.

- Le Transfer Learning est la capacité d’améliorer un modèle existant en tranferrant la connaissance d’une autre source d’un domaine proche. Pour imager ce transfert de connaissance, prenons pour éxemple le transfert de la reconnaissance d’un vélo opur un modèle qui reconnait un scooter. <Lien article ‘A comprehensive Survey on Transfer Learning’>.

Ces approches peuvent s’avérer complexes à exploiter en raison des efforts nécessaires à la sélection des échantillons, à la recherche de modèles pertinents, … mais malgré l’effort « humain » nécessaire pour appréhender et mettre en œuvre ces approches, les gains liés aux ressources « machines » consommées pendant l’entrainement peuvent s’avérer conséquent.

Dans l’exemple du monde agricole, le speaker revient sur “un problème rencontré pour l’évaluation de la santé du bovin. Un agriculteur peut, avec l’application qu’ils ont développé, prendre en photo de vache de profil ainsi que de derrière et une IA va analyser la forme de l’animal pour retourner un indice sur l’état de santé. Or, il a été constaté que l’IA ne se focalisait pas sur la forme de l’animal, mais sur ses tâches, en faisant la correspondance avec les animaux d’entrainement sur la base de ce critère. Pour régler ce problème, l’équipe de développement à décider de segmenter les photos en se concentrant sur la forme d’une partie de l’animal. Ainsi la correspondance se fait via la forme.“ Cet exemple d’augmentation de la donnée par la sélection, le découpage démontre l’intérêt d’une telle méthode. Il soulève ensuite ”une autre problématique qui concernait le faible pool de données pour l’entrainement, ce qui a été solutionné par une autre technique d’augmentation de donnée, en procédant soit par un Undersampling, ou un Oversampling. Enfin, pour sélectionner les features les plus intéressantes, une ACP a été réalisée.“

Enfin, pour la partie interprétation, “les calculs des valeurs sont réalisées directement dans le front end de l’application. Ceci la rend plus rapide et suis la démarche « ecoresponsable by design ».“ Cette approche est souvent incontournable pour que le modèle soit exploitable au niveau opérationnel : application déconnectée, faible couverture des réseaux, temps de réponse limité, … mais il s’avère également plus frugale en rapprochant les données du modèle et en limitant ainsi les coûts liés à la collecte et à la centralisation des données. Il faudra malgré tout resté vigilant pour s’assurer que ces modèles déportés restent cohérents les uns avec les autres…

Pour en savoir plus :

Depuis plusieurs années, la Data est perçue comme le nouvel or noir qui vient soutenir et alimenter la transformation digitale des organisations. Les investissements ont été nombreux dans le domaine et ont largement dépassé le cadre des entreprises pour arriver sur le domaine public à l’heure actuelle.

On voit aujourd’hui que les données sont exploitées dans des domaines très variés : accélération de l’innovation pour soutenir l’économie locale, amélioration de la qualité de vie en adaptant l’accompagnement des citoyens. Mais la formation et la sensibilisation des différentes parties prenantes reste un vaste chantier :

- Amélioration des pratiques pour une technologie moins énergivores,

- Mise en avant des solutions alternatives à l’I.A. pour des applications plus frugales,

- Sensibilisation des acteurs aux usages de la donnée et à une démarche éthique

Autant de sujets qui nous conduiraient vers une meilleure maitrise de notre patrimoine de données et donc une Data plus responsable…