IA & DevOps : quels enjeux futurs ?

Sommaire

- Les tendances à surveiller

- L’approche Cloud Native

- L’IA au service de DevOps

- Marketplaces & gestion centralisée

- Vers une nouvelle culture de l’innovation

- Conclusion

Les tendances à surveiller

L’Intelligence Artificielle (IA) et le DevOps sont deux forces technologiques majeures qui, ensemble, promettent de transformer radicalement le paysage informatique. Alors que les pratiques DevOps ont déjà permis de réduire les silos entre les équipes de développement et d’opérations, l’IA vient aujourd’hui amplifier cette dynamique, offrant des opportunités inédites pour automatiser, optimiser et accélérer encore davantage les processus.

Dans cet article, nous explorerons les enjeux futurs au croisement de l’IA et du DevOps, en mettant en lumière 4 tendances majeures. D’abord, l’essor du Cloud Native, qui redéfinit l’architecture des applications en favorisant une plus grande agilité et scalabilité. Ensuite, l’IA elle-même, qui devient un catalyseur pour le DevOps en automatisant les tâches répétitives, en optimisant les ressources en temps réel, et en permettant une prise de décision plus éclairée. Nous aborderons aussi l’importance croissante des marketplaces centralisées, qui autonomisent les équipes tout en garantissant la cohérence des environnements de développement. Enfin, nous aborderons de la culture d’innovation continue, indispensable pour maintenir un avantage concurrentiel dans un monde en perpétuelle évolution.

L’approche Cloud Native

Dans le domaine du DevOps, plusieurs technologies influentes ont émergé ces dernières années, façonnant l’avenir des pratiques et des outils. Parmi celles-ci, nous pouvons mentionner le Cloud Native.

Le Cloud Native est une évolution de la virtualisation. En effet, alors que la virtualisation permettait de créer plusieurs machines virtuelles sur un seul serveur physique pour optimiser l’utilisation des ressources, l’approche Cloud Native va plus loin. Elle utilise des conteneurs et des orchestrateurs comme Kubernetes pour déployer et gérer des applications de manière plus agile, scalable et résiliente. Elle favorise ainsi une utilisation optimale et dynamique des infrastructures cloud.

Les pilliers fondamentaux de l’approche Cloud Native

L’adoption de l’approche Cloud Native transforme fondamentalement la manière dont les applications sont développées, déployées et gérées. Voici quelques éléments clés, qui constituent les piliers de cette approche :

L’architecture microservices

L’architecture microservices permet de décomposer les applications en services indépendants, facilitant leur déploiement et leur scalabilité.

Les conteneurs

Les conteneurs sont une technologie de virtualisation légère qui permet d’exécuter des applications et leurs dépendances dans des environnements isolés. Des outils comme Docker et Kubernetes sont utilisés pour gérer les conteneurs, assurant une portabilité et une efficacité optimales. Les conteneurs simplifient le déploiement et la gestion des applications en permettant de les exécuter de manière cohérente dans différents environnements, du développement à la production. Ils jouent un rôle clé dans la mise en œuvre de l’architecture microservices et dans la réalisation des objectifs DevOps.

Les API (Application Programming Interface)

Les API (Application Programming Interface) sont des interfaces qui permettent aux différentes applications de communiquer entre elles. Dans une architecture Cloud Native, les API facilitent l’intégration et l’interopérabilité des services. Elles permettent aux microservices de se connecter et de partager des données de manière sécurisée et efficace. Une bonne gestion des API est cruciale pour assurer la sécurité, la performance et la traçabilité des interactions entre les services. Les solutions d’API Management permettent de contrôler et de surveiller ces interactions, assurant une connectivité fluide et fiable.

La culture DevOps

Enfin, la culture DevOps vise à améliorer la collaboration entre les équipes de développement (Dev) et d’opérations (Ops). En intégrant les principes DevOps, les entreprises peuvent automatiser les processus de déploiement, réduire les cycles de développement et améliorer la qualité du logiciel. La mise en place de pipelines CI/CD (Continuous Integration/Continuous Deployment) est essentielle dans cette démarche. Les pipelines CI/CD permettent d’automatiser les tests, les builds et les déploiements, assurant ainsi une livraison rapide et fiable des logiciels. Cette automatisation réduit les risques d’erreurs humaines et améliore la réactivité des équipes face aux besoins du marché.

Ces quatre piliers – Microservices, Conteneurs, API et DevOps – sont interdépendants et ensemble, ils forment la base de l’approche Cloud Native. En adoptant ces principes, les entreprises peuvent créer des systèmes plus résilients, scalables et innovants, répondant ainsi efficacement aux exigences modernes du marché et améliorant leur compétitivité globale.

Les pratiques indispensables

En complément des piliers fondamentaux du Cloud Native, certaines pratiques et méthodes sont indispensables pour garantir une mise en œuvre efficace :

- GitOps est une méthodologie clé dans l’écosystème Cloud Native. Git est considéré comme l’unique source de vérité, l’épine dorsale pour gérer les infrastructures et les déploiements d’applications.

- L’utilisation d’outils comme « Terraform » ou « Ansible », tous deux inscrits dans la méthodologie GitOps, assurent la gestion de l’infrastructure via des fichiers de configuration et donc une automatisation complète. Ils offrent également une traçabilité des modifications et une cohérence des environnements déployés.

- Les outils d’observabilité comme Prometheus ou Grafana permettent une surveillance avancée des systèmes. Ils fournissent des insights détaillés sur les performances et facilitant la détection et la résolution rapide des problèmes.

- Enfin, les services mesh permettent de gérer la complexité des microservices et d’intégrer l’approche DevSecOps. Un service mesh est une infrastructure dédiée qui gère la communication entre les services dans une architecture microservices. Il permet de gérer et de contrôler le trafic, de sécuriser les communications internes avec des fonctionnalités comme le chiffrement (mTLS) ou l’authentification, et de fournir une observabilité avancée. Avec des outils comme Istio et Linkerd, les services mesh facilitent la gestion des communications complexes. Ils améliorent la résilience des applications et renforcent la sécurité des microservices.

Les avantages du Cloud Native

Adopter une approche Cloud Native simplifie considérablement la mise en œuvre du DevOps comparé aux infrastructures Legacy. Dans un environnement Cloud Native, les technologies modernes comme les conteneurs, les microservices et les outils de gestion automatisée (IaC, CI/CD) offrent une flexibilité et une scalabilité inégalées. Les services mesh et les solutions d’API Management permettent une intégration fluide et sécurisée des composants. La combinaison de ces technologies facilite l’automatisation, améliore la collaboration entre les équipes et accélère les cycles de développement et de déploiement.

La mise en œuvre du DevOps sur des infrastructures Legacy est également possible, bien que cela nécessite souvent plus d’efforts. Les systèmes Legacy peuvent être intégrés dans des pipelines CI/CD et bénéficier d’une automatisation accrue. Cependant, ils nécessitent souvent des adaptations spécifiques en raison de leur nature monolithique et de leur complexité historique. Industrialiser sur du Legacy implique souvent de moderniser progressivement les systèmes existants, de mettre en place des ponts entre les anciennes et les nouvelles technologies, et de gérer des dépendances complexes.

La modernisation des infrastructures via une approche Cloud Native permet aux entreprises de répondre plus rapidement aux évolutions du marché et de maintenir un avantage compétitif. En intégrant DevOps dans une stratégie de modernisation Cloud Native, les organisations transforment leurs processus internes et maximisent leur efficacité opérationnelle.

Bien que le Cloud Native offre un cadre plus adapté et moins contraignant pour l’implémentation de DevOps, il est possible d’appliquer ces pratiques à des infrastructures Legacy. Avec des efforts supplémentaires, les entreprises peuvent tout à fait surmonter les défis inhérents à ces environnements plus traditionnels.

Le choix entre Cloud Native et Legacy dépend donc des objectifs de l’entreprise, de ses ressources et de sa volonté de moderniser ses infrastructures. Les organisations doivent garder à l’esprit l’importance d’une transformation progressive et bien gérée.

L’IA au service de DevOps

L’intégration de l’intelligence artificielle (IA) dans le DevOps est devenue une étape incontournable pour les entreprises cherchant à optimiser l’efficacité, la qualité et la sécurité de leurs processus de développement logiciel. Cette convergence apporte plusieurs avantages significatifs que nous allons détailler ci-après :

L’IA offre la possibilité d’automatiser des tâches complexes, réduisant les erreurs humaines et accélérant les processus de déploiement et de gestion des applications. En prenant des décisions autonomes sur des questions telles que l’optimisation des ressources, la gestion des charges de travail et la correction automatique des erreurs, l’IA libère les équipes DevOps de nombreuses tâches répétitives. Elles peuvent ainsi se concentrer sur des aspects plus stratégiques et créatifs de leur travail.

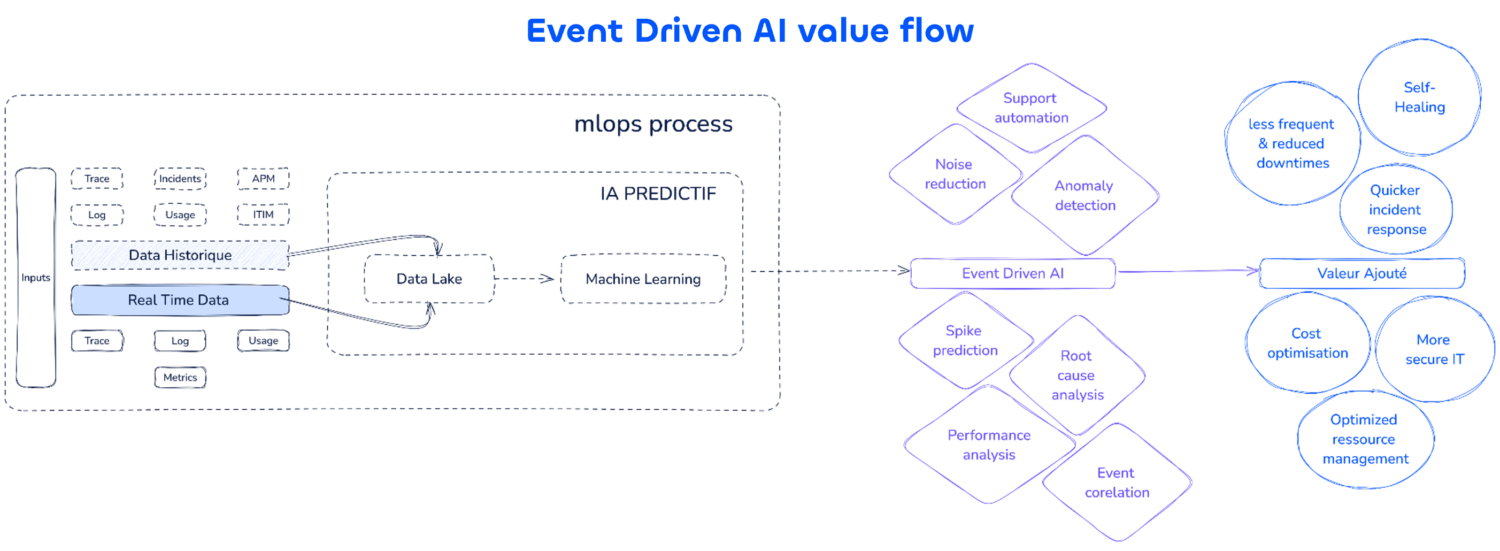

Détection (prévision) et correction automatique des anomalies

L’IA est utilisée pour surveiller en temps réel les métriques de performance des applications, telles que le temps de réponse, les taux d’erreur et les comportements utilisateurs anormaux. Des algorithmes de machine learning détectent (et prédisent) les anomalies et déclenchent automatiquement des processus de correction :

Les pratiques SRE se combinent efficacement avec les capacités de self-healing de l’IA. Ensemble, elles automatisent la détection et la correction des anomalies, réduisant ainsi significativement les interruptions de service.

Optimisation des ressources en temps réel

L’IA analyse en continu les modèles de demande et les performances des systèmes, ajustant dynamiquement l’allocation des ressources en fonction des besoins réels.

L’intégration de l’IA dans le DevOps permet une gestion plus fine et réactive des ressources, ce qui optimise à la fois les coûts et les performances. L’IA utilise des algorithmes de machine learning pour analyser les données historiques et en temps réel, anticipant les besoins futurs et ajustant les ressources en conséquence. Par exemple, si une application reçoit plus de trafic pendant certaines heures de la journée, l’IA peut augmenter les ressources pendant ces périodes pour maintenir des performances optimales.

En optimisant l’allocation des ressources, l’IA évite les gaspillages et réduit donc les coûts d’infrastructures. Cette approche a un impact positif sur la consommation énergétique et les émissions de CO2.

L’intégration de l’IA dans la gestion des ressources permet donc une optimisation des coûts en temps réel en assurant une utilisation efficace des infrastructures.

Automatisation des pipelines de CI/CD

L’IA est intégrée dans les pipelines de Continuous Integration/Continuous Deployment (CI/CD) pour automatiser les tests, la vérification du code, et le déploiement. Elle apprend des précédents déploiements pour prédire les issues potentielles et recommander des améliorations.

L’Intelligence Artificielle dans les pipelines CI/CD transforme radicalement le processus de développement et de déploiement des logiciels. En automatisant les tests, elle permet de détecter rapidement les bugs et les vulnérabilités, garantissant, ainsi, que chaque modification du code est rigoureusement vérifiée avant d’être mise en production. Cette automatisation réduit non seulement les erreurs humaines mais accélère également les cycles de développement. En effet, les tests manuels, souvent longs et fastidieux, sont remplacés par des tests automatisés et continus.

De plus, l’IA analyse les résultats des tests et les déploiements précédents afin d’identifier les patterns et les causes récurrentes d’échecs. Grâce à cette capacité d’apprentissage, elle peut prédire les problèmes potentiels avant qu’ils ne se produisent et proposer des solutions proactives. Par exemple, si un certain type de changement dans le code a souvent conduit à des erreurs dans le passé, l’IA peut alerter les développeurs et suggérer des ajustements ou des tests supplémentaires afin d’éviter que le problème ne se reproduise.

L’amélioration de la qualité du code est également notable. Avec des feedbacks instantanés fournis par l’IA, les développeurs reçoivent des informations précises et exploitables sur les erreurs et les points d’amélioration dès qu’ils soumettent leur code. Cela permet de corriger les problèmes immédiatement, avant qu’ils ne deviennent plus complexes et coûteux à résoudre. Ainsi, le code déployé en production est plus stable et de meilleure qualité.

Enfin, l’IA optimise le déploiement en automatisant les processus de mise à jour des environnements de production. Elle peut gérer les déploiements progressifs, en surveillant la performance des nouvelles versions tout en ajustant les déploiements en fonction des résultats observés. Cela permet de minimiser les interruptions de service et d’assurer une transition en douceur pour les utilisateurs.

En conclusion, l’intégration de l’IA dans les pipelines CI/CD réduit les délais de mise en production améliore la qualité du code. Elle permet aussi de renforcer la fiabilité et l’efficacité globale du processus de développement et de déploiement des logiciels.

Marketplaces & gestion centralisée

En ce qui concerne les tendances influentes, nous retrouvons les Marketplaces (self-service). Pour rappel, ces approches permettent aux équipes de développement de provisionner et de gérer leurs propres environnements, réduisant la dépendance aux équipes IT traditionnelles et accélérant les cycles de développement.

L’importance de ces approches réside dans leur capacité à autonomiser les développeurs, en leur fournissant les outils et les ressources nécessaires pour créer, tester et déployer des applications de manière indépendante. Cela s’intègre parfaitement avec les principes de DevOps qui visent à améliorer la collaboration et à réduire les silos entre les équipes de développement et d’opérations.

Les Marketplaces, par exemple, offrent une plateforme centralisée où les développeurs peuvent accéder à une gamme de services, d’applications et de plateformes, facilitant ainsi l’intégration continue (CI), le déploiement continu (CD) et la livraison continue (CD). Ces outils aident à standardiser les environnements de développement, réduisant les variations et les erreurs qui peuvent survenir lors des déploiements manuels.

Une passerelle vers les Internal Developer Platforms (IDP)

Les Marketplaces et la gestion centralisée constituent également une passerelle naturelle vers la mise en place des Internal Developer Platforms (IDP). Les IDP fournissent un environnement intégré où les développeurs peuvent accéder à tous les outils, services et informations nécessaires pour leur travail, optimisant ainsi leur productivité et leur efficacité.

Les IDP s’appuient sur les mêmes principes de standardisation et d’automatisation que les Marketplaces, mais vont encore plus loin en offrant une interface unifiée pour toutes les ressources de développement. Cela inclut non seulement les services cloud et les environnements de déploiement, mais aussi les pipelines CI/CD, les outils de gestion du code, les services de monitoring et de logging, et bien plus encore.

En intégrant les Marketplaces dans une IDP, les entreprises peuvent offrir une expérience de développement encore plus cohérente et fluide. Les développeurs bénéficient d’un accès simplifié à tout ce dont ils ont besoin, réduisant les frictions et les délais associés à la configuration et à la gestion des environnements de développement et de production.

Cette intégration permet également de renforcer la sécurité et la conformité, en centralisant la gestion des politiques et des configurations. Les équipes peuvent ainsi garantir que toutes les applications respectent les mêmes standards de qualité et de sécurité, indépendamment de l’équipe ou de l’individu qui les développe.

L’adoption des Marketplaces combinée au Platform Engineering et à la mise en place des IDP, représente une avancée significative vers l’optimisation des processus de développement et de déploiement des applications. Ces approches accélèrent les cycles de développement, améliore la qualité des livrables et réduisent les coûts opérationnels, tout en permettant aux équipes de se concentrer sur l’innovation et la valeur ajoutée.

En résumé, les portails self-service se concentrent sur la consommation et le provisioning des ressources, tandis que les IDP unifient l’accès aux outils et services nécessaires aux développeurs. Ensemble, ils représentent des solutions cruciales pour rationaliser les usages à grande échelle.

Vers une nouvelle culture de l’innovation

Dans le monde du DevOps, adopter une culture de l’innovation continue est essentiel. DevOps ne se limite pas à une série de pratiques et d’outils, mais incarne une philosophie de remise en question perpétuelle et d’amélioration constante. Cette approche promeut un environnement dynamique et évolutif, évitant le piège d’un système stagnant et non adaptable dans lequel de nombreuses entreprises se retrouvent piégées.

Pour favoriser cette culture d’innovation, il est crucial de concevoir dès le départ des solutions flexibles et prêtes à évoluer avec les besoins changeants. Cela implique d’investir dans des architectures et des processus qui permettent une adaptation rapide et sans friction. En intégrant l’innovation continue comme principe fondamental, les équipes peuvent anticiper et gérer les changements sans accumuler de dette technique significative.

Encourager une telle culture nécessite également de valoriser l’expérimentation et l’apprentissage. Les équipes doivent être encouragées à essayer de nouvelles approches, à échouer rapidement et à tirer des enseignements de ces échecs pour s’améliorer. Cela signifie également promouvoir la collaboration ouverte et la communication constante entre les différentes équipes, garantissant que les innovations et les améliorations sont partagées et mises en œuvre de manière cohérente à travers toute l’organisation.

Enfin, cette culture de l’innovation continue doit être soutenue par les instances dirigeantes et intégrée dans la vision stratégique de l’entreprise. Cela nécessite des investissements en termes d’outils, de formation et de ressources nécessaires pour maintenir un environnement propice à l’évolution. En mettant l’accent sur une culture d’amélioration continue, les entreprises peuvent non seulement éviter de s’enliser dans une dette technique lourde, mais aussi rester compétitives et agiles face aux défis futurs.

Dans les pages suivantes, nous allons examiner l’importance de cette logique d’innovation dans l’adoption des pratiques DevOps, ainsi que son impact sur l’attractivité des entreprises dans un marché de plus en plus compétitif.

Par ailleurs, l’attractivité d’une entreprise pour ses collaborateurs internes, ses nouveaux talents et ses prestataires externes est directement liée à la modernité et à l’innovation de sa stack technologique. Une entreprise qui investit dans des outils modernes, des pratiques avancées et une culture d’innovation continue attire non seulement les meilleurs talents mais aussi les meilleurs partenaires.

Pour les employés actuels, travailler dans un environnement qui encourage l’innovation et utilise des technologies de pointe est motivant et enrichissant. Cela favorise la rétention des talents et leur engagement envers l’entreprise. Les professionnels de la tech sont attirés par les défis intellectuels et les opportunités de développement professionnel que seul un environnement innovant peut offrir.

En ce qui concerne le recrutement, les candidats recherchent des entreprises qui adoptent des pratiques modernes. Avoir une stack technologique attrayante est un avantage compétitif majeur dans la guerre des talents du numérique. Les développeurs, ingénieurs DevOps et autres professionnels de l’informatique sont plus enclins à rejoindre une entreprise qui investit dans l’innovation et la modernisation continue de ses infrastructures.

De même, les prestataires et partenaires externes préfèrent collaborer avec des entreprises qui possèdent une approche innovante. Cela assure une meilleure synergie, une efficacité accrue et des résultats plus rapides et de meilleure qualité. Un environnement technologique avancé et bien structuré facilite également l’intégration et la collaboration avec des tiers.

En somme, une culture d’innovation continue et une stack technologique attrayante sont essentielles non seulement pour la compétitivité et l’agilité de l’entreprise mais aussi pour attirer et retenir les meilleurs talents et partenaires. En adoptant les pratiques avancées du DevOps, les entreprises se positionnent comme des leaders technologiques, prêts à relever les défis futurs et à innover constamment.

Conclusion

En conclusion, l’intégration de l’Intelligence Artificielle (IA) dans les pratiques DevOps ouvre de nouvelles perspectives pour l’avenir des équipes techniques. Ce mariage entre IA et DevOps ne se contente pas de transformer les outils et les processus : il redéfinit également les compétences et les rôles des professionnels du DevOps.

Désormais, le profil DevOps ne se limite plus à une expertise spécifique. Pour réussir dans ce domaine en constante évolution, il est essentiel de posséder un socle de connaissances varié, englobant la gestion du code avec Git, la sécurité des systèmes, l’administration des serveurs, et bien plus encore. Cette évolution vers une polyvalence accrue impose un changement culturel profond, où la collaboration interdisciplinaire devient la norme, et où l’apprentissage continu est indispensable.