Artificial Intelligence Act

Un projet de règlement européen fondé sur une approche par les risques : une opportunité pour les professionnels de la cybersécurité

Introduction

Le Parlement européen a adopté, le 14 juin dernier, un projet de règlement destiné à encadrer le développement et les usages des intelligences artificielles au sein de l’Union Européenne. Le projet pour l’Artificial Intelligence Act (AIA) entre désormais dans la phase dite des trilogues, afin d’être discuté entre les représentants du Parlement, du Conseil et de la Commission européenne, avec pour objectif d’aboutir à un règlement pour la fin 2023, et qui entrerait en application en 2026.

Relancées par la mise en service médiatisée de l’agent conversationnel ChatGPT, développé par l’entreprise américaine OpenAI, les discussions sur la réglementation des intelligences artificielles avaient pourtant débuté dès 2018 au niveau européen. Si ces technologies promettent, selon l’UE, des avancées considérables dans un grand nombre de domaines, ses dérives potentielles pourraient toutefois représenter une menace « pour la sécurité des consommateurs et utilisateurs et pour les droits fondamentaux ». Ainsi, le Parlement, à travers ce projet, exprime son ambition de faire de l’UE un leader en matière d’« intelligence artificielle sûre, fiable et éthique », en s’assurant que les « systèmes d’intelligences artificielles utilisées dans l’UE soient transparents, traçables, non discriminatoires et respectueux de l’environnement ».

Ce projet de réglementation se fonde, au même titre que pour le RGPD, sur une approche basée sur les risques : les IA identifiées comme présentant un « risque élevé » qui prétendront être commercialisées / utilisées au sein de l’UE devront suivre un processus de gestion des risques en vue de leur homologation. Mais puisque l’AIA ne spécifie pas, à ce stade, la marche à suivre, l’élaboration de ce cadre méthodologique en matière de gestion et d’identification des risques relatifs aux intelligences artificielles représente donc une opportunité nouvelle, en particulier pour les métiers de la cybersécurité. Outre cette absence de dimension pratique, des critiques sont ponctuellement formulées à l’encontre du projet de l’Artificial Intelligence Act, du fait de ses contours jugés trop flous par les uns, et trop restrictifs pour l’innovation par les autres. Cet article propose donc un tour d’horizon des différents enjeux posés par ce projet de réglementation particulièrement innovant.

L’AIA : tour d’horizon

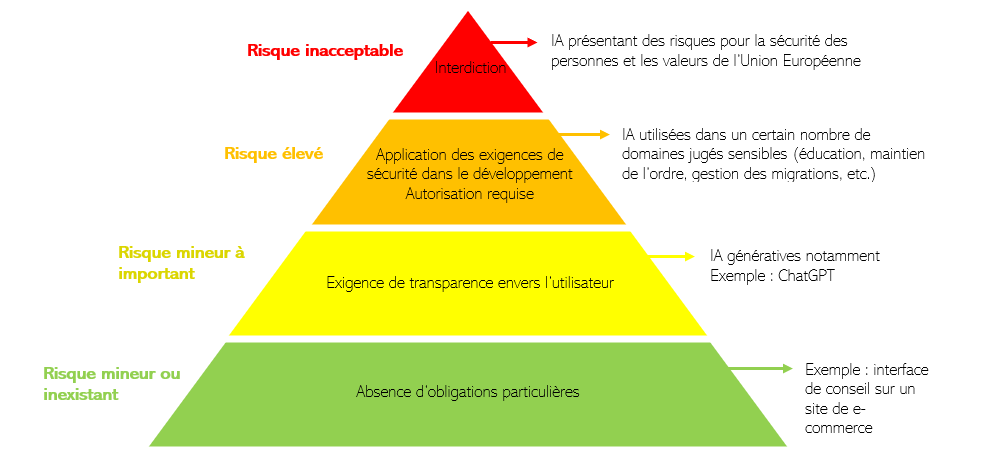

Concrètement, l’Artificial Intelligence Act classera les intelligences artificielles en 4 catégories, en fonction du niveau de risques encouru du fait de leur utilisation : minimal/inexistant, important, haut et inacceptable. En fonction de cette caractérisation, l’AIA définira un ensemble d’exigences à respecter, le cas échéant, avant la mise du produit sur le marché européen.

Les IA présentant un risque minimal ou inexistant n’auront pas d’obligations ou d’exigences particulières avant leur mise sur le marché.

Les IA présentant un risque plus important sont désignées comme celles devant faire preuve de transparence : elles devront informer qu’elles sont des IA, labeliser les deepfakes (contenu multimédia créé par une intelligence artificielle) comme tels, préciser les contenus soumis aux droits d’auteurs ou encore préciser les systèmes utilisés pour leur fonctionnement (identification biométrique par exemple). Dans les faits, ce type de catégorie s’applique principalement aux IA génératives, tel ChatGPT.

Les IA présentant un risque élevé (ou à « haut risque ») constituent la principale catégorie prise en charge par l’AIA. En dehors des produits dont la commercialisation relève déjà d’une législation européenne en matière de sécurité (l’aviation, les voitures, les dispositifs médicaux, etc.), l’usage de l’intelligence artificielle est réputé hautement risqué au sein de 8 domaines :

- La reconnaissance par les données biométriques et leur collecte au sein de bases de données ;

- La gestion et l’exploitation des infrastructures critiques (électricité, eau, etc.) ;

- L’éducation et la formation professionnelle ;

- L’emploi et les ressources humaines ;

- L’accès aux services publics et aux services privés essentiels ;

- Le maintien de l’ordre ;

- La gestion des migrations, de l’asile et du contrôle aux frontières ;

- L’assistance à l’interprétation et à l’application de la loi.

Ainsi, pour chacune des technologies se basant sur l’intelligence artificielle utilisée au sein de l’un de ces domaines, le fournisseur devra justifier de la conformité de sa technologie avec les exigences fixées par l’AIA, en vue de l’obtention du label CE, qui autorise sa mise sur le marché européen. Parmi ces exigences, on compte notamment :

- La garantie d’un contrôle humain ;

- La garantie de la robustesse, de l’exactitude et de la cybersécurité ;

- La garantie d’un certain degré de transparence envers les utilisateurs ;

- L’établissement d’une documentation de la conception ;

- L’établissement de fonctionnalités de journalisation de la conception ;

- L’utilisation de données d’entrainement, de validation et de tests de haute qualité.

Enfin, les IA présentant un risque inacceptable seront interdites. Elles désignent des IA présentant un risque pour la sécurité des personnes, ou allant à l’encontre des valeurs de l’Union Européenne. A ce titre, le projet pour l’AIA a d’ores et déjà prévu d’interdire les systèmes de notation sociale ou de reconnaissance faciale au sein de l’espace public -sauf exceptions, en cas de lutte contre la criminalité et le terrorisme ou pour la recherche de personnes disparues.

L’AIA : un enjeu pour les métiers de la cybersécurité

Les intelligences artificielles identifiées comme à « haut risque » (ou risque élevé) constituent donc les technologies auxquelles l’AIA impose le plus de contrôles et d’exigences. Le fournisseur doit tout d’abord développer son IA selon des exigences strictes, rappelées plus haut. Puis, le fournisseur doit obtenir l’autorisation de commercialiser son produit au sein de l’Union européenne, autorisation qui s’obtient à deux conditions :

- L’observation d’une phase de tests, afin d’identifier d’éventuelles vulnérabilités et de s’assurer du bon fonctionnement de l’IA en dehors de l’environnement de développement. Cela permet notamment d’identifier les cas de décalage distributionnel, résultants d’une IA dont le fonctionnement (voire le comportement) en production n’est pas le même que lors de son développement/de sa phase d’apprentissage.

- L’établissement, par le fournisseur, d’un processus de gestion des risques.

Ce processus de gestion des risques devra inclure l’ensemble des risques qu’une IA peut présenter, des impacts environnementaux liés à des coûts de calculs potentiellement colossaux aux risques de cyberattaques. A ce titre, il apparait que la mise en place de ce système de gestion des risques soulève un enjeu spécifique aux professionnels de la cybersécurité. En effet, selon l’AIA, un processus de gestion des risques appliqué aux intelligences artificielles se décline ainsi :

- Identification des sources de menaces potentielles / des risques pour l’IA

- Estimation de la probabilité d’occurrence des risques pour l’IA

- Adoption des mesures de gestion des risques en conséquence

Or, au sein de la communauté des professionnels de la cybersécurité, ni les méthodes d’identification des risques, ni les normes en matière de gestion des risques propres aux intelligences artificielles ne sont harmonisées et stabilisées, et encore moins définies par l’Artificial Intelligence Act. Si certaines organisations européennes de normalisation [1] ont été mandatées par l’UE pour élaborer ces normes techniques, ce travail pourrait prendre plusieurs années.

Toutefois, la publication récente de référentiels de gestion des risques propres aux intelligences artificielles tend à doter les professionnels d’un cadre commun dans l’élaboration de dispositifs de gestion des risques. Sans être spécifiques à la gestion des risques cyber, l’ISO/IEC 23894:2023 ou encore l’AI Risk Management Framework, publié par le NIST américain (National Institute of Standards and Technology), pourraient constituer un socle méthodologique commun aux professionnels de la cybersécurité à cette fin.

Les travaux en matière d’identification des menaces cybers portées par les intelligences artificielles émergent également. La taxonomie des risques propres aux IA est de plus en plus fournie, mais doit encore être complétée. Là encore, plusieurs travaux de recensement des risques portés par les intelligences artificielles peuvent être cités, comme la publication de ATLAS (Adversial Threat Landscape for Artficial-Intelligence Systems) par le MITRE ATT&CK, un cadre recensant les tactiques d’attaques pouvant menacer ce type de technologie.

A titre d’exemple, le NIST identifie dans ses travaux plusieurs risques portés par les IA, parmi lesquels :

- Les attaques de type oracle, lors desquelles l’IA sollicitée répond aux requêtes d’un attaquant, permettant à ce dernier d’obtenir des informations sur le système ciblé, généralement dans le but de porter atteinte à la confidentialité des modèles de l’IA ou aux données manipulées par l’IA ;

- Les attaques d’extraction de modèle, consistant à dérober le modèle ou les paramétrages d’une IA en soumettant un certain nombre de requêtes ;

- Les attaques par reprogrammation, consistant à faire exécuter par l’IA une tâche non prévue par sa programmation initiale. Par exemple, si une IA est initialement programmée pour de la reconnaissance d’images, un attaquant pourrait utiliser une API d’apprentissage automatique pour en altérer l’algorithme. Tout en se basant sur le modèle d’apprentissage initial de l’IA, ces manipulations pourraient conduire à un usage détourné de celle-ci, comme le minage de cryptomonnaies dans le cas de la reconnaissance d’images ;

- Les attaques plus traditionnelles, comme les attaques par déni de service.

Ainsi, l’élaboration des pratiques en matière d’identification et de gestion des risques, et la mise en commun des sources de menaces liées aux IA, constituent certains des principaux enjeux posés par l’AIA aux professionnels de la cybersécurité.

[1] Comme : the European Committee of Standardization (CEN), the European Committee for Electrotechnical Standardization (CENELEC) et the European Telecommunications Standards Institute (ETSI)

Les limites de l’AIA et ses critiques

Plusieurs limites à l’AIA peuvent être identifiées, au-delà de son manque d’orientations pratiques en matière de gestion des risques. De même, plusieurs critiques sont ponctuellement formulées envers ce projet de régulation des intelligences artificielles, au premier rang desquelles on retrouve la crainte qu’une réglementation trop contraignante entraverait l’innovation.

La principale limite de ce projet concerne certains de ses aspects qui demeurent flous, et qui appellent à être explicités par le règlement final. C’est par exemple le cas de la réalisation et de la validation des tests préalables à l’autorisation de mise sur le marché, pour lesquels les autorités compétentes n’ont pas été clairement identifiées. Par ailleurs, l’exigence d’établir un dispositif de gestion des risques ne s’appliquant qu’aux IA identifiées comme à « haut risque » peut être considérée comme trop restrictive, certains risques pouvant être sous-estimés.

En effet, les critères pour la classification du niveau de risque porté par un produit, en vue de son autorisation, appellent à être plus rigoureusement définis. On peut imaginer, par exemple, un fournisseur présentant une technologie comme une IA générative, qui ne serait donc soumise qu’à une obligation de transparence. Or, dans la pratique, cette IA générative pourrait s’avérer capable d’élaborer un code informatique pour le développement d’un programme à risque, dans le nucléaire civil par exemple. Selon les catégories établies par l’AIA, cette IA générative s’affranchirait des restrictions imposées aux IA à « haut risques », bien que certains de ses usages pourraient clairement relever de cette catégorie. Dans ce cas de figure, purement théorique, l’autorité européenne compétente trancherait probablement pour un principe de précaution, considérant par défaut que la plupart des IA génératives relèvent des IA à « haut risque », comme le redoute Cédric O, ancien secrétaire d’Etat au numérique et fondateur de Mistral AI.

Cet exemple conduit à une critique plus large sur la réglementation des intelligences artificielles : l’encadrement des IA entraverait les usages et les innovations en la matière. Présentant un « risque fort de gêner l’innovation en Europe » selon un proche de Cédric O, l’Intelligence Artificial Act pourrait, par ses contraintes, ralentir le développement et la commercialisation de technologies développées en Europe basées sur l’Intelligence Artificielle.

Ayant indiqué partager cette inquiétude, Emmanuel Macron a, dans le même temps, présenté un plan de financement de 500 millions d’euros destiné à soutenir le développement des intelligences artificielles françaises, en favorisant le développement de centres de recherche, ou encore en soutenant le développement de supercalculateurs. De son côté, le projet pour l’AIA prévoit aussi une feuille de route pour l’établissement d’une politique volontariste en matière de développement des intelligences artificielles européennes, sans toutefois en préciser le financement :

- Faire de l’Union européenne un lieu d’excellence pour la recherche et la commercialisation des intelligences artificielles ;

- Etablir les conditions favorables au développement et à la captation des ressources de déploiement des intelligences artificielles (données, calculateurs, connaissances, etc.) ;

- Développer un leadership stratégique dans l’IA appliquée aux secteurs de l’environnement, de la santé, de la robotique, de l’agriculture, etc.

Au-delà de leur développement, c’est finalement l’usage des intelligences artificielle, au sein de l’Union européenne, qui est pris en charge par l’AIA. De ce côté, la France a pu se montrer encline à développer l’usage des intelligences artificielles à des fins sécuritaires, dans le sillage de l’organisation des jeux olympiques et paralympiques de Paris, en 2024. La loi éponyme, adoptée en mars 2023, autorise notamment l’usage de la surveillance algorithmique dans l’espace public (technologie de vidéosurveillance capable d’identifier des situations définies au préalable comme anormales). Faisant de la France une pionnière en Europe en matière de légalisation autorisant la surveillance biométrique, cette disposition s’est vue renforcée, trois mois plus tard, par l’adoption au Sénat d’une proposition de loi visant à autoriser les technologies de reconnaissance faciale au sein de l’espace public. Ce projet de loi, adopté deux jours avant le vote du projet de l’AIA, qui prévoyait précisément d’interdire ce type de technologies dans l’espace public, ouvre le débat sur les bénéfices d’une législation pérenne, comme l’Artificial Intelligence Act, face à des besoins plus ponctuels, en l’occurrence sécuritaires.

Résumés du projet :

- Risk Management in the Artificial Intelligence Act (Cambridge University Press, 8 février 2023)

- AI Risk Management Framework : Second Draft (NIST, National Institution of Standards and Technology, 18 août 2022)

- NIST AI RMF (Risk Management Framework) Playbook

- Norme ISO/IEC 23894:2023 – Technologie de l’information – Intelligence Artificielle – Recommandations relatives au management du risque

- MITRE ATT&CK – ATLAS (Adversial Threat Landscape for Artficial-Intelligence Systems)

- Petite taxonomie des attaques des systèmes d’IA (LINC, Laboratoire d’Innovation Numérique de la CNIL, 4 avril 2022)

Articles de presse :

- Intelligence artificielle : négociations tendues autour du projet de règlement européen AI Act (Le Monde, 18 juillet 2023)

- Emmanuel Macron veut créer des concurrents français des modèles d’OpenAI ou Google (Le Monde, 14 juin 2023)