Retour sur le salon BIG DATA et AI Paris 2022

La practice Data du Néosoft était présente sur cette nouvelle édition [2022] du plus grand salon français dédié au monde de la Data. L’occasion, pour nos experts, de vous partager leurs retours d’expériences.

Nos consultants comme autant de DATA explorateurs

Néosoft était présent cette année pour l’édition 2022 du salon du BIG DATA et AI Paris. Ce fut l’occasion pour notre practice Data de présenter ses convictions : « vous accompagner vers une Data plus responsable ». Nous y avons également animé conjointement avec la Banque de France un retour d’expérience autour de la mise en place de leur Data Catalog.

Mais ce n’est pas tout, ce fut également l’occasion pour certains de nos experts Data de découvrir le salon et ces nombreux ateliers… Ce sont leurs retours d’expérience que vous retrouverez tout au long de cet article !

Nous avons bien évidemment abordé ce salon sous le prisme de l’exposant mais pas seulement… Nos consultants ont également pu assister aux ateliers présentés tout au long des deux jours de salon. Voici notamment les retours de Kyllian et de Nourddine, deux experts Data chez Néosoft.

Parlons conférences tout d’abord…

Un salon, c’est avant tout l’occasion de mettre en lumière les belles réalisations, collaborations ou innovations. Voici les retours d’expériences de Néosoft, d’Orano ou du Crédit Agricole qui ont retenu notre attention !

#1 – Mise en place d’un Data Catalog, un projet Banque De France x Néosoft

Profitons-en pour nous arrêter quelques instants sur le REX présenté par Rudy LEROUX, Responsable du Service des Référentiels de la Banque de France et Christophe ROUXEL, architecte DATA chez Néosoft. Ensemble, ils sont revenus sur la mise en place d’un DATA CATALOG au sein de la Banque de France.

#2 – Projet de maintenance prédictive chez ORANO

L’entreprise ORANO a fait appel à un partenaire dans le cadre de la mise en place d’une stratégie de maintenance prédictive. Le but de ce sujet était de déterminer la probabilité de défaillance d’un équipement ou d’une machine au sein de leur chaine de retraitement des combustibles nucléaires usés. Cette démarche permettant d’éviter des réparations coûteuses et de maximiser l’utilisation et la disponibilité de l’équipement en service.

Le principal challenge à relever était déformaliser des algorithmes de machine learning entrainés avec un historique (30 ans) de comptes rendus d’intervention au format texte de techniciens de maintenance. Et ceci dans le but de modéliser la prédiction d’une typologie de panne à un horizon temporel (6 mois à l’avance).

Comment répondre à ce challenge ?

L’experte a proposé d’utiliser la méthodologie NLP afin de répondre à ce challenge. Le NLP (Natural Language Processing)est une branche de l’intelligence artificielle qui s’occupe particulièrement du traitement du langage écrit.

Détails de la stratégie ?

La première phase avait pour objectif de vérifier la présence des patterns utiles dans les données au travers des 3 étapes ci-dessous :

- Exploration et nettoyage des données

- Classement des comptes rendus d’intervention en clusters (catégories d’évènements ex : panne électrique)

- Catégorisation des clusters par niveau de gravité

Résultats : Cette première phase a permis de valider la prédictibilité des données ainsi que l’implémentation d’une IA réutilisable sur d’autres contexte de maintenance prédictive.

La deuxième phase avait pour objectif de modéliser la prédiction d’une typologie de panne à un horizon temporel au travers des 3 étapes ci-dessous :

- Etude approfondie de la phase 1

- Validation des patterns de pannes

- Modélisation de la prédiction des prochaines pannes

Résultats : Cette deuxième phase a permis de valider un modèle permettant d’identifier les pannes structurantes 6 mois à l’avance.

L’avis de notre expert : Cette approche vient en opposition avec une exploitation brute des données opérationnelles par les modèles. Un choix intéressant dans la démarche retenue pour ce projet chez ORANO. En effet, l’exploitation des comptes-rendus permet une labellisation des données. Cette étape peut s’avérer complexe et fastidieuse mais permet, par la suite, d’atteindre un niveau de fiabilité en général plus élevé.

#3 – Catalogue de service chez Crédit Agricole

Cette conférence proposée par le Crédit agricole, et animée par Julien LEGRAND, Product Owner chez CA-GIP, débute en nous expliquant que construire une offre de service c’est : “industrialiser le déploiement d’une solution technique complexe en y ajoutant un ensemble d’outils permettant de rendre autonome l’utilisateur final”.

Pour illustrer cette définition, le speaker nous a ensuite partagé deux cas d’usage d’application critique. Et notamment, l’application “Ma Banque” qui se doit d’être performante puisqu’elle totalise 8 millions de clients et affiche 1000 requêtes par seconde.

Porté par une démarche Agile à l’échelle, CA-GIP est le principal garant de l’infrastructure de cette application. Cette organisation leur permet notamment de proposer des services hautement disponibles basés sur une distribution répartie sur plusieurs datacenters. Une implication qui va même jusqu’à fournir la configuration des infrastructures, OS et autres applications.

Pour illustrer le niveau de service attendu, le speaker est revenu sur la migration d’un cluster Kafka composé de “2 datacenters à 3 brokers (2×3)” à “3 datacenters à 2 brokers (3×2)”. Cette transformation permettant une plus haute disponibilité fut rendue possible par le mode IaaS et la définition de règles d’utilisation de leurs futurs services.

Autre problématique très impactante : celle de l’hybridation via Kubernetes et l’ouverture vers le cloud public. Avec Kubernetes, l’idée fut de pouvoir déployer un service sur le socle approprié tout en favorisant le passage vers le cloud public. Ce passage a notamment permis de profiter de services managés avec de fortes capacités d’infrastructure.

L’avis de notre expert : il est intéressant de noter que la transition technologique proposée a été initiée pour répondre aux usages métiers du crédit agricole à travers ce catalogue de service.

… Parlons maintenant des outils !

Un salon : ce sont également des nouveautés et des innovations technologiques qui permettent de mettre à l’honneur des langages ou des outils. Voici ceux qui ont tapé dans l’œil de nos experts !

#4 – L’exploitation des données financières de BIC

Cette session a démarré par la mise en exergue des problématiques de performances et de temps de réponse rencontrées par le métier finance de BIC. Plus précisément, dans le cadre de la réalisation d’analyses détaillées sur de forte volumétries de données (+ 1 milliard de data).

Le challenge à relever :

- Pouvoir analyser une très grosse volumétrie de données

- Disposer de reporting avec des temps de réponse performants

- Etre capable de naviguer facilement au travers des différentes granularités des données

Comment était consommée la data chez BIC ?

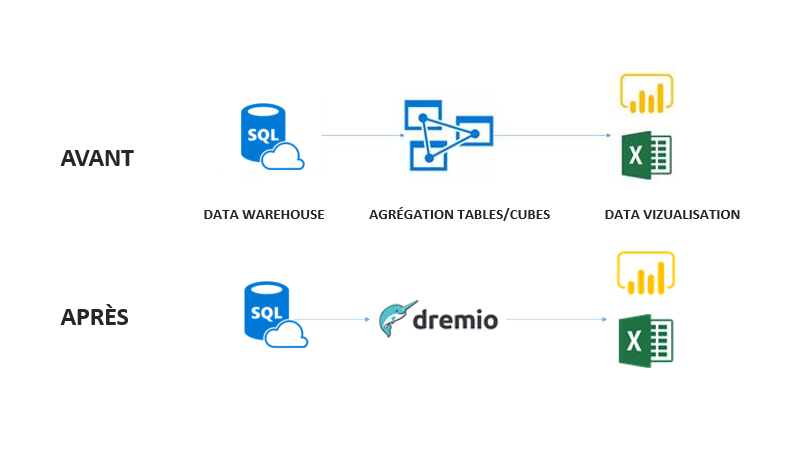

Architecture BI traditionnelle où la donnée ne cesse d’être copiée « zone de consolidation (Data staging), zone structurée (DataWarehouse) », en essayant de la rendre performante pour les utilisateurs au travers de la création de plusieurs couches de données.

Fort du constat des limites rencontrées dans le cadre de l’utilisation de modèles tabulaires volumineux, cette architecture oblige à augmenter sans cesse la mémoire afin de préserver des performances correctes pour les utilisateurs.

Comment répondre à ce challenge ?

Il a fallu réfléchir à une architecture scalable permettant d’accroître ses capacités de calcul en fonction de l’évolution de la volumétrie de données avec pour objectifs de garantir le détail, la rapidité d’exécution et le niveau de granularité des requêtes utilisateurs.

La solution retenue ?

La solution retenue consistait à mettre en place une couche d’accélération des requêtes qui vient s’intercaler entre les données sources et les outils dataviz (PowerBI) au travers de l’utilisation de DREMIO (Datalake engine). Cet outil a permis donc de s’affranchir de la couche DataWarehouse/Cubes offrant une unique surcouche SQL fédérant l’ensemble des datasources en entrée.

Les avantages

En synthèse, voici les avantages mis en avant par BIC lors de ce retour d’expérience :

- Accélération/gestion du cache

- Pas de réplication de la donnée

- Gestion du rafraichissement incrémental

- Un licensing qui ne dépend pas du volume de données

- Un modèle de sécurité viable

- User friendly

- Assure la gouvernance des données (Data mesh)

L’avis de notre Expert : DREMIO est un outil à fort potentiel, à tester pour accélérer l’accès à vos données ! Il est dans notre raod map de d’amélioration continue.

#5 – Présentation de la solution Taipy.io

Taipy est un framework Python qui permet de faire des applications web en low code. Il est composé de :

- Taipy GUI pour la réalisation de front-end

- Taipy Core pour le back-end.

C’est à l’aide d’un notebook Jupyter que le speaker nous a présenté les fonctionnalités du framework en commençant par le Taipy GUI. Très vite la facilité de création d’une interface web est démontrée via la création d’un graphique représentant les données Covid ainsi qu’un sélecteur qui va mettre à jour automatiquement le visuel. Dans un second temps, c’est au tour de Taipy Core qui va gérer la partie modélisation de pipeline et gestion des scénarios.

Une particularité très intéressante de la solution est la mise en cache des résultats de chaque tâche. Ainsi si une sortie est utilisée par deux pipelines différents, la mise en cache de la sortie va permettre de gagner du temps lors de l’exécution du deuxième pipeline. La présentation se conclue par la connexion de Taipy GUI avec Taipy Core pour créer une plateforme de machine learning avec simulation de scénarios.

L’avis de notre expert : de mon point de vue, cet outil est la petite pépite de ce salon : à tester assurément !

Pour en savoir plus sur notre practice DATA ou sur ce salon, vous pouvez contacter nos experts!